Trabajos de programador Spark

En Turing, tenemos vacantes de programador Spark remoto para limpiar, transformar y analizar grandes cantidades de datos brutos de distintos recursos, utilizando Spark para proveer datos listos para ser utilizados a los desarrolladores y analistas de negocios. Esta es tu oportunidad de impulsar tu carrera trabajando para las mejores compañías de Silicon Valley.

Descubre trabajos remotos en software con centenas de clientes de Turing

Descripción del puesto

Responsabilidades del puesto

- Crear trabajos Scala/Spark para transformación y recolección de datos.

- Procesar gran cantidad de datos estructurados y no estructurados.

- Escribir unit tests para la transformación de datos.

- Instalar, configurar y mantener el entorno empresarial Hadoop.

- Asignar esquemas utilizando tablas Hive e implementar clusters HBase.

- Diseñar pipelines de procesamiento de datos.

- Utilizar herramientas ETL para cargar datos de diferentes fuentes en la plataforma Hadoop.

- Desarrollar y verificar documentación técnica.

- Mantener la seguridad y la privacidad de los clusters Hadoop.

Requisitos mínimos

- Experiencia en tecnologías tales como Storm, Apache Kafka, Hadoop, etc.

- Licenciatura/Máster en Informática (o experiencia equivalente).

- Experiencia trabajando en entornos de datos complejos y de gran escala.

- +3 años de experiencia trabajando en aplicaciones basadas en Spark (con algunas excepciones para candidatos sumamente capacitados).

- Experiencia práctica en Hive, Yarn, HDFS, HBase, etc.

- Buen dominio de lenguajes de programación como Scala, Java, or Python

- Experiencia trabajando en productos ETL, como Ab Initio, Informatica, Data Stage, etc.

Habilidades preferidas

- Experiencia en escribir consultas SQL complejas y en importar y exportar grandes cantidades de datos utilizando herramientas.

- Habilidad para escribir componentes de código abstractos y reutilizables.

- Comunicación y coordinación de distintos equipos.

- Capacidad para trabajar en equipo y gran atención a los detalles.

¿Interesado en este trabajo?

Aplica a Turing hoy mismo.

¿Por qué unirse a Turing?

1Empleos de élite en EE. UU.

2Crecimiento profesional

3Asistencia al Desarrollador

¿Cómo convertirse en un desarrollador de Turing?

Crea tu perfil

Completa tus datos básicos: nombre, ubicación, conocimientos, expectativa salarial y experiencia.

Realiza nuestras pruebasy entrevistas

Resuelve pruebas y asiste a una entrevista técnica.

Recibe ofertas de trabajo

Las mejores empresas de EE.UU. y Silicon Valley te elegirán como colaborador.

Obtén el trabajo de tus sueños

Una vez que seas parte de Turing, ya no tendrás que volver a buscar otro trabajo.

¿Cómo convertirse en desarrollador Spark?

Debido a su alta velocidad, su facilidad de uso y analítica compleja, Spark ha crecido exponencialmente en los últimos años, convirtiéndose en el motor analítico de procesamiento de datos y de IA más eficaz en las empresas en la actualidad. Spark tiene un costo elevado porque requiere mucha RAM para ejecutarse en memoria.

Spark combina datos e IA facilitando la preparación de datos a gran escala a partir de diversas fuentes. También cuenta con un conjunto uniforme de APIs para cargas de trabajo de ingeniería y ciencia de datos y se integra perfectamente con librerías populares como TensorFlow, PyTorch, R y SciKit-Learn.

Spark vs Hadoop

Hadoop fue diseñado para manejar el procesamiento por lotes de manera eficiente, mientras que Spark está diseñado para manejar los datos en tiempo real de manera eficiente. Hadoop es un framework de alta latencia, que no tiene un modo interactivo, mientras que Spark es de baja latencia y puede procesar los datos de forma interactiva.

La popularidad de Spark ha aumentado en el último tiempo, ya que cada vez más empresas confían en los datos para desarrollar sus estrategias de negocio. Por lo tanto, el desarrollo de Spark es indudablemente una opción de carrera estable y bien remunerada para ti.

¿Cuál es el alcance del desarrollo Spark?

La big data es el futuro, y Spark proporciona un amplio conjunto de herramientas para manejar enormes cantidades de datos en tiempo real. Spark es una tecnología de futuro por su iluminación, velocidad, tolerancia a fallos y procesamiento eficaz en memoria.

Las consultas SQL, los datos en streaming, el machine learning (ML) y el procesamiento de gráficos son compatibles con este motor unificado.

- Para cargas de trabajo menores, procesamiento en memoria, almacenamiento de datos en disco y otras técnicas, es cien veces más rápido que Hadoop.

- Para la manipulación y transformación de datos semiestructurados se dispone de APIs sencillas de utilizar.

El desarrollo web ha avanzado a un nivel que nadie podía siquiera imaginar hace 20 años. Spark es uno de los motores de análisis unificados de código abierto más populares en la actualidad, y tendrás muchas opciones profesionales en el campo del desarrollo Spark.

¿Cuáles son las funciones y responsabilidades de un desarrollador Spark?

Las principales funciones de un desarrollador Spark incluyen proporcionar datos listos para su uso a los desarrolladores de funciones y a los analistas empresariales mediante el análisis de cantidades masivas de datos sin procesar procedentes de diversos sistemas. Esto abarca tanto las solicitudes ad-hoc como los pipelines de datos incorporados en nuestro ámbito de producción.

Las principales responsabilidades de un trabajo de desarrollador Spark remoto incluyen:

- Escribir código ejecutable de componentes, análisis y servicios de Spark.

- Aprender lenguajes de programación esenciales como Java, Python y Scala.

- Conocer Apache Kafka, Storm, Hadoop y Zookeeper, así como otras tecnologías relevantes.

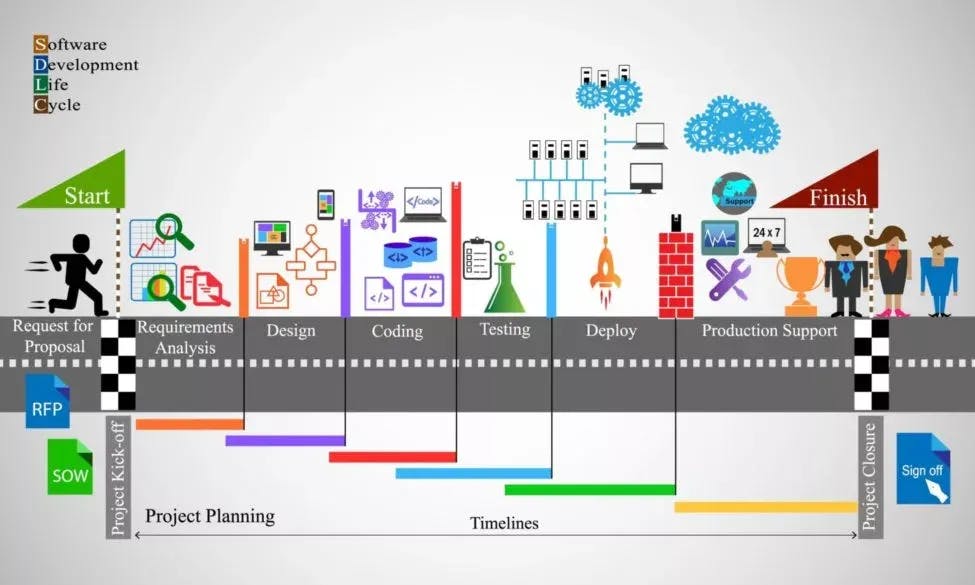

- Estar preparado para manejar el análisis del sistema, que abarca el diseño, la codificación, las unit tests y otras tareas de SDLC.

- Tomar las necesidades del usuario y transformarlas en tareas técnicas sólidas, y brindar estimaciones de costos.

- Validar la precisión del análisis técnico y la experiencia en la resolución de problemas.

- Evaluar el código y el caso de uso para confirmar que cumple con las especificaciones.

¿Cómo convertirse en un desarrollador Spark?

Hay una línea muy fina entre convertirse en un desarrollador Spark certificado y ser un verdadero desarrollador Spark capaz de trabajar en una aplicación en tiempo real.

A continuación, te ofrecemos algunas recomendaciones para ayudarte a encontrar trabajos remotos de desarrollo Spark.

- Para ser un experto, debes seguir el camino correcto con la asistencia en tiempo real de profesionales certificados de la industria.

- También puedes inscribirte en cualquiera de los programas de formación y certificación (desarrollador spark big data cloudera, entre otros)

- Una vez iniciado el proceso de certificación, debes comenzar a trabajar en tus propios proyectos para poner en práctica lo aprendido.

- Los RDDs (Resilient Distributed Datasets) y los Dataframes son los principales componentes de construcción de Spark. Es necesario conocerlos.

- Spark también puede integrarse con varios lenguajes de programación de alto rendimiento, como Python, Scala y Java. Los RDDs de PySpark son el mejor ejemplo del trabajo conjunto de Python y Apache Spark.

- Después de dominar los fundamentos de Spark, puedes pasar a entender los principales componentes para convertirte en desarrollador Apache Spark, que se enumeran a continuación: - SparkML-Lib - Spark GraphX - SparkR - Spark Streaming

- Una vez que hayas completado la formación y la certificación necesarias, en la medida de lo posible, es el momento de practicar lo que has aprendido.

¿Estás interesado en trabajos remotos de desarrollador Spark?

¡Conviértete en un desarrollador de Turing!

Habilidades necesarias para convertirse en un desarrollador Spark

El primer paso para conseguir trabajos remotos de desarrollador Spark es aprender las habilidades básicas. Ahora, veamos cuales son las mismas:

1. Framing y análisis de Big Data

El análisis de big data utiliza técnicas analíticas avanzadas para conjuntos de datos extensos y diversos, que pueden contener datos estructurados, semiestructurados y no estructurados, así como datos de muchas fuentes y tamaños que van desde terabytes hasta zettabytes. Esta es una habilidad esencial para conseguir trabajos remotos de desarrollador Spark.

2. Python

Python es un lenguaje de programación de alto nivel y de propósito general. Su filosofía de diseño enfatiza la legibilidad del código mediante el uso de mucha sangría. El enfoque orientado a objetos de Python está desarrollado para ayudar a los programadores a escribir un código claro y lógico tanto para proyectos pequeños como a gran escala.

3. Scala

Scala es un acrónimo que significa Lenguaje Escalable. Es un lenguaje de programación con múltiples paradigmas. El lenguaje de programación Scala combina técnicas de programación funcional y orientada a objetos, y es estáticamente tipado. Su código fuente se convierte en bytecode y es ejecutado por la máquina virtual Java (JVM).

4. Java

Java es un lenguaje de programación orientado a objetos con pocas dependencias de implementación. Se garantiza que el lenguaje de programación Java es un lenguaje de escritura única y ejecución en cualquier lugar. Un programa Java se compila en bytecode durante la compilación. Este formato de código de bytes es independiente de la plataforma, lo que significa que puede ejecutarse en cualquier máquina, y también proporciona seguridad. Los programas Java pueden ejecutarse en cualquier dispositivo que tenga instalado el Java Runtime Environment.

5. Spark SQL

Spark SQL es un módulo de Spark de procesamiento de datos estructurados. Ofrece DataFrames como abstracción de programación y también puede servir como motor de consulta SQL distribuido. También tiene una fuerte conexión con el resto del ecosistema de Spark (por ejemplo, integrando el procesamiento de consultas SQL con machine learning).

6. Spark streaming

Spark Streaming es una extensión de la API de Spark que permite a los ingenieros y científicos de datos analizar datos en tiempo real de varias fuentes, incluyendo (pero no limitado a) Kafka, Flume y Amazon Kinesis. Los datos pueden ser trasladados a los sistemas de archivos, bases de datos y tableros de control en vivo después de haber sido analizados.

7. MLlib

MLlib es una librería de machine learning escalable construida sobre Spark que incluye clasificación, regresión, agrupación, filtrado colaborativo, reducción de la dimensionalidad y primitivas de optimización subyacentes, así como otros métodos y utilidades de aprendizaje estándar.

8. Elastic MapReduce

Amazon Elastic MapReduce (EMR) es un servicio web que proporciona un framework gestionado para ejecutar frameworks de procesamiento de datos de forma fácil, rentable y segura, incluyendo Apache Hadoop, Apache Spark y Presto. Se utiliza para diversos fines, como el análisis y almacenamiento de datos, la indexación en línea, el análisis financiero y la simulación científica. Es importante dominarlo para conseguir los mejores trabajos de desarrollador Spark.

9. Spark DataFrames y Datasets

Los conjuntos de datos son una extensión de los frameworks de datos en Spark. Esencialmente, gana dos tipos de características de la API: fuertemente tipado y no tipado. A diferencia de los frameworks de datos, los conjuntos de datos son por defecto una colección de objetos JVM fuertemente tipados. También hace uso del optimizador Catalyst de Spark.

10. Librería GraphX

GraphX combina el ETL, el análisis exploratorio y el cálculo reiterado de gráficos en un solo sistema. La API de Pregel le permite ver los mismos datos como gráficos y colecciones, transformar y combinar rápidamente gráficos con RDs, e implementar algoritmos de gráficos repetitivos personalizados.

¿Estás interesado en trabajos remotos de desarrollador Spark?

¡Conviértete en un desarrollador de Turing!

¿Estás interesado en trabajos remotos de desarrollador Spark?

El desarrollo de Spark es una de las carreras más flexibles ya que te permite trabajar desde cualquier lugar con una conexión a Internet y una computadora. Si tu trabajo lo permite, puedes trabajar desde casa o desde tu lugar de trabajo favorito!

El trabajo remoto tiene muchas ventajas. Además, la competencia también ha aumentado en el último tiempo. Por lo tanto, para conseguir trabajos remotos de desarrollador Spark, tienes que conocer tus habilidades técnicas y establecer una rutina de trabajo productiva.

Turing tiene los mejores trabajos remotos de desarrollador Spark que se adaptan a tus objetivos profesionales. Trabajar en problemas tecnológicos y empresariales difíciles con tecnologías de vanguardia te ayudará a crecer rápidamente. Únete a la red de los mejores desarrolladores del mundo y consigue un trabajo de desarrollador Spark remoto full-time y a largo plazo con mayores ingresos y crecimiento profesional.

¿Por qué convertirse en desarrollador Spark en Turing?

Empleos de élite en EE.UU.

Oportunidades a largo plazo para trabajar en grandes empresas estadounidenses, orientadas a un objetivo y con una gran compensación.

Crecimiento profesional

Trabaja en problemas técnicos y empresariales desafiantes utilizando tecnología de vanguardia para acelerar el crecimiento de tu carrera.

Comunidad exclusiva de desarrolladores

Únete a una comunidad mundial de desarrolladores de software de élite.

Una vez que te unas a Turing, nunca más tendrás que buscar otro trabajo

Los compromisos de Turing son a largo plazo y a tiempo completo. Cuando un proyecto llega a su fin, nuestro equipo se pone a trabajar para identificar el siguiente en cuestión de semanas.

Trabaja desde la comodidad de tu casa

Turing te permite trabajar según tu conveniencia. Tenemos un horario flexible y puedes trabajar para las mejores empresas de Estados Unidos desde la comodidad de tu casa.

Gran compensación

Al trabajar con las principales empresas de EE.UU., los desarrolladores de Turing ganan más que el salario estándar del mercado en la mayoría de los países.

¿Cuánto le paga Turing a los desarrolladores Spark?

Cada desarrollador puede seleccionar su rango salarial de acuerdo a sus habilidades y experiencia. Sin embargo, en Turing sugerimos un monto con el que podremos encontrar una buena oportunidad a largo plazo. La mayoría de nuestras recomendaciones se basan en el análisis de las condiciones actuales del mercado y las demandas de nuestros clientes.

Preguntas Frecuentes

Últimas entradas de Turing

Liderazgo

Política de Igualdad de Oportunidades

Explora trabajos remotos de desarrollador

Basadas en tus conocimientos

- React/Node

- React.js

- Node.js

- AWS

- JavaScript

- Python

- TypeScript

- Python/React

- Java

- PostgreSQL

- React Native

- PHP

- PHP/Laravel

- Golang

- Ruby on Rails

- Angular

- Android

- iOS

- ASP.NET

Basadas en tu rol

+ Ver más rolesBasadas en tu trayectoria profesional

- Desarrollador de Software

- Desarrollador de Software Senior

- Ingeniero de Software

- Ingeniero de Software Senior

- Desarrollador Senior Full-stack

- Desarrollador Senior Front-end

- Ingeniero Senior de DevOps

- Desarrollador Java Senior

- Líder Técnico de Software Senior